Мы создали самого начитанного в мире попугая. GPT-4 может сдать экзамен на адвоката, написать сонет в стиле Шекспира или сгенерировать сложный код на Python. Но попробуйте попросить его спланировать сложный логистический маршрут с меняющимися условиями, и магия исчезнет.

Фундаментальная проблема современных больших языковых моделей (LLM) заключается в их архитектуре. Трансформер — это, по сути, машина предсказания следующего слова. Автодополнение на стероидах.

"Модель не 'понимает', что 2+2=4. Она просто знает, что после токенов '2+2=' с высочайшей вероятностью следует токен '4'."

Эта вероятностная природа делает их великолепными в творчестве и интуиции, но абсолютно ненадежными в рассуждениях (Reasoning). Они галлюцинируют факты с той же уверенностью, с какой излагают истину, потому что для нейросети понятия "истина" не существует — есть только вероятность.

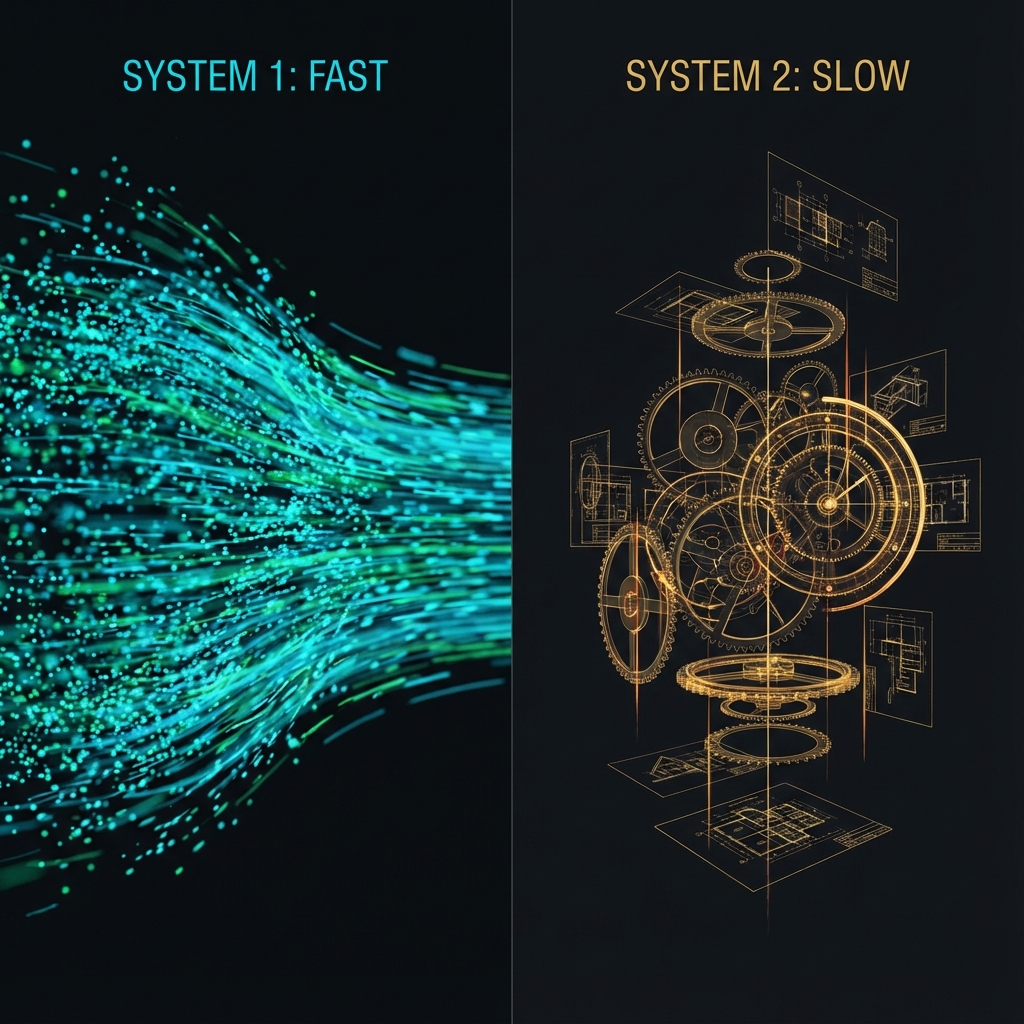

Система 1 против Системы 2

Нобелевский лауреат Даниэль Канеман разделял человеческое мышление на два типа:

- Система 1 (Быстрая): Интуитивная, автоматическая, бессознательная. "Сколько будет 2+2?", "Лицо друга в толпе". Работает мгновенно, но с ошибками.

- Система 2 (Медленная): Логическая, последовательная, требующая усилий. "Умножьте 17 на 24", "Спланируйте бюджет". Требует времени и концентрации.

Рис 1. Дихотомия процессов мышления

Недостающее звено

Современный ИИ — это чистая Система 1. Он генерирует ответ за миллисекунды, не "думая" перед тем, как сказать. У него нет внутреннего монолога, нет черновика, нет возможности остановиться и проверить свои выводы.

В AIFusion мы строим архитектуры, обладающие Системой 2. Это сети, которые могут:

- 01. Отложить ответ и запустить процесс поиска решения.

- 02. Разбить сложную задачу на подзадачи (декомпозиция).

- 03. Критически оценить свой промежуточный результат (саморефлексия).

Нейро-символический синтез

Чистые нейросети плохи в логике. Старый символический ИИ (GOFAI) был хорош в логике, но беспомощен в реальном мире. Будущее — за их объединением.

Мы интегрируем нейронные модули (для восприятия и интуиции) с жесткими символическими решателями (для математики и формальной логики). Это позволяет системе не галлюцинировать при расчетах, а обращаться к встроенному "калькулятору" или базе знаний, точно так же, как это делает человек.

Рекурсия и Циклы Мышления

Классический трансформер — это feed-forward сеть: вход -> слои -> выход. Один проход. Когнитивная архитектура должна быть рекурсивной. Она должна уметь гонять информацию по кругу, уточняя и улучшая её.

Мы внедряем механизмы "Chain of Thought" (цепочка рассуждений) не как промпт-инжиниринг, а как фундаментальный архитектурный примитив. Сеть генерирует скрытые мысли, оценивает их, отбрасывает тупиковые ветви и только потом формирует финальный ответ пользователю.

Базовые Исследования

Теоретический фундамент наших когнитивных архитектур.

Общая Теория Глупости

Анализ когнитивных искажений в системах ИИ. Почему «умные» модели принимают идиотские решения и как внедрить архитектурную «рациональность».

Читать PaperRecursive Reasoning Nets

Предстоящая публикация о реализации рекурсивных циклов мышления в мультимодальных агентах.

Скоро